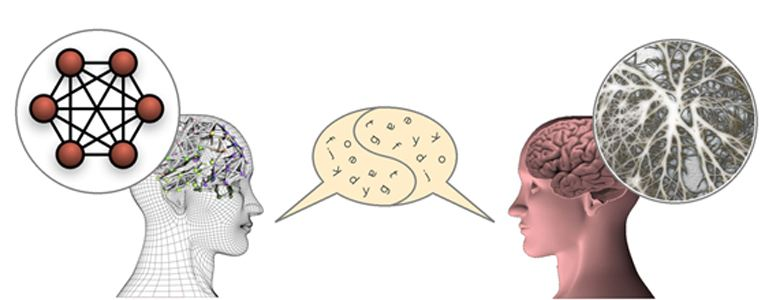

人工智能学习人类的语言 与此同时也学会了人类思想

语言是关于重复的。你正在阅读的每一个字都是由人造的,然后由其他人使用,创造和加强语境,意义,语言本质。当人类训练机器来理解语言时,他们正在教学机器来复制人的偏见。

普林斯顿大学信息技术政策中心的Aylin Caliskan说:“我们能够展示和证明的主要科学发现是语言反映了偏见。“如果AI接受人类语言的培训,那么它将一定会吸收这些偏见,因为它代表了关于世界的文化事实和统计数据。”

Caliskan的工作与合着者Joanna Bryson和Arvind Narayanan一起上周在科学出版。从本质上讲,他们发现如果有人训练机器来理解人类语言,那么它将会吸收那些内在的偏见。

在人类中,测试偏见的最好方法之一是隐含的关联测试,它要求人们将一个像“昆虫”这样的单词与“愉快”或“不愉快”等词相关联,然后测量延迟或时间采取做这个连接。人们快速将昆虫标记为令人不愉快和较慢的标签,令人愉快,所以这是一个很好的指标。

在计算机上测试犹豫并不奏效,所以研究人员发现了一种不同的方式来看电脑更愿意与别人联系在一起。像学生猜测一个不熟悉的单词的意思只是基于附近出现的单词,研究人员训练了一个人工智能,将相互联系在一起的单词联系在一起,而不是将不相关的单词相关联。

将每个单词作为三维空间中的向量设想。通常在同一句子中使用的单词更接近于它,并且在句子中很少使用的单词是向量越远。两个词越接近,机器越有可能联系起来。如果人们说“程序员”靠近“他”和“电脑”,但是说“护士”靠近“她”和“服装”,这说明了语言的隐含偏见。

给计算机这种语言数据来教他们不是一个新概念。斯坦福全球矢量图像表示法之类的工具,在这种纸张之间存在的基础上,相关词之间的向量。GloVe的单词包括从20亿个推文中提取的270亿字,维基百科在2014年提取了60亿字,通过互联网从随机拖网中提取了840亿字。

因此,计算机正在通过将与工作有关的词与特定的性别或族裔群体联系起来,来种族主义和性别歧视。本文强调的一个例子是“程序员”,这不是英文的性别词,而是通过使用它现在具有男性职业的内涵。

除非人们在编程机器上使用人类语言来解释这些现有的偏差,那么它们将不会产生一种无偏见的机器,而是一种复制人类偏见的机器。

延伸 · 阅读

- 2015-11-03戴尔与中科院共建“人工智能与先进计算联合实验室”揭牌

- 2015-11-04中科院自动化所与戴尔合作建立“人工智能与先进计算联合实验室”

- 2016-01-09中科院自动化所成立人工智能创投基金

- 2016-01-15百度宣布开源人工智能代码

- 2016-01-26哈佛大学欲打造速度和人脑一样快人工智能