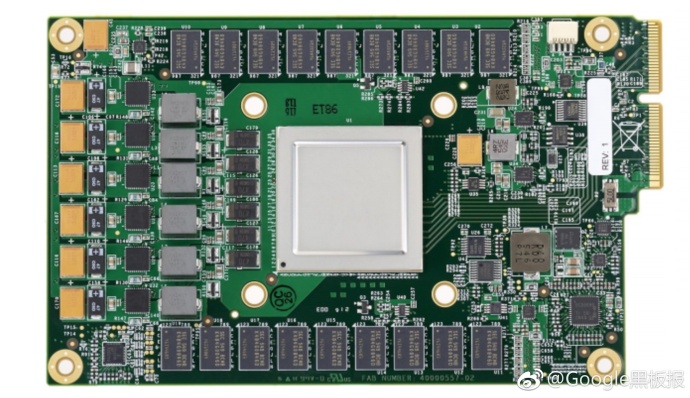

Google为机器学习定制的加速器:TPU(Tensor Process Unit)

在机器学习领域,计算机的运算速度尤为重要。为此,Google 设计了为机器学习定制的加速器:TPU(Tensor Process Unit)。

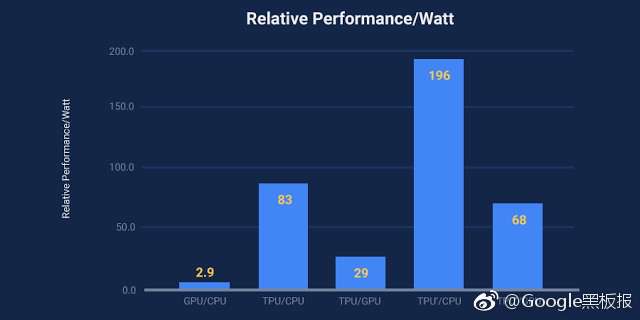

相比传统芯片,TPU 在进行人工智能相关运算时速度可达 GPU 和 CPU 的 15 至 30 倍。同时,TPU 体积更小,内存容量更大,还实现了更低的能耗。

谷歌首次详细地介绍了这种芯片的相关信息。除了发表一篇有75位联合作者的论文《In-Datacenter Performance Analysis of a Tensor Processing UnitTM》外,谷歌资深硬件工程师Norman Jouppi刊文表示,相比类似的服务器级Intel Haswell CPU和NVIDIA K80 GPU,TPU的性能的确斐然:

1、在神经网络层面的操作上,处理速度比当下GPU和CPU快15到30倍;

2、在能效比方面,比GPU和CPU高30到80倍;

3、在代码上也更加简单,100到1500行代码即可以驱动神经网络;

同时谷歌还表示,由于TPU专为机器学习所运行,得以较传统CPU、GPU降低精度,在计算所需的电晶体数量上,自然可以减少,也因此,可从电晶体中挤出更多效能,每秒执行更复杂、强大的机器学习模组,并加速模组的运用,使得使用者更快得到答案。